Fonte:

Open

Autore:

Antonio di Noto

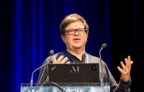

Mentre Goldman Sachs metteva in guardia contro i 300 milioni di posti di lavoro che potrebbero andare persi a causa dell’intelligenza artificiale, Yann LeCun professava la calma, sostenendo che l’AI, a discapito del nome, non è poi così intelligente. Vincitore del premio Turing nel 2018, tra i pionieri del machine learning, docente alla New York University, lo scienziato francese classe 1960 è da dieci anni Chief AI Scientist di Meta. Ieri, 3 luglio, ha ricevuto la laurea ad honorem dall’Università di Siena ed è stato ospite d’onore dell’evento SAIConference, dedicato al rapporto tra etica e futuro. Le sue opinioni si discostano da quelle di molti altri grandi nomi del settore, che non solo vedono nell’AI – oltre che una grande opportunità – un pericolo da domare, ma addirittura un rischio di estinzione per genere umano.

In un’intervista alla Bbc a giugno hai detto che l’intelligenza artificiale di oggi è meno intelligente di un cane. Lo pensa ancora?

«È paradossale vero? Abbiamo sistemi che ci battono a scacchi e a poker. Abbiamo sistemi che riescono agilmente a superare l’esame per l’avvocatura e rispondere a domande complicatissime recuperando informazioni da ogni dove. Ma non abbiamo un sistema in grado di sparecchiare la tavola o di caricare la lavastoviglie. Due cose che qualsiasi bambino di 10 anni è in grado di imparare in 10 minuti. E ancora, non siamo ancora riusciti a creare delle auto a guida autonoma, eppure un 17enne qualsiasi in poco tempo impara a guidare. Qualcosa manca. Abbiamo computer incredibilmente abili nel linguaggio ma che non capiscono molto del mondo intorno a loro; non sanno pensare e pianificare nella maniera in cui lo fanno gli animali e gli esseri umani. I modelli di linguaggio vengono addestrati chiedendo loro di predire l’ultima parola di una frase. Conoscono solo il testo. Sono in corso delle sperimentazioni con i video per dare all’AI una comprensione del mondo. Alcune porzioni vengono tagliate e la macchina deve immaginarle, ma ancora non ci siamo. Quando ciò sarà possibile, forse l’AI sarà intelligente come i nostri cani o i nostri gatti».

Lei è tra i pochi esperti a non temere che l’AI toglierà milioni di posti di lavoro. Eppure, secondo un report sul mercato statunitense, solo lo scorso maggio il 5% dei posti di lavoro persi è da attribuire all’intelligenza artificiale…

«Penso al trend storico. Ci sono dati su moltissime innovazioni tecnologiche, e nessuna di queste ha cambiato i livelli d’impiego. I lavori cambiano, alcuni nascono altri muoiono, ma la tecnologia non influisce sui tassi di disoccupazione. Quello mostrato dal rapporto potrebbe dunque essere un effetto transitorio dovuto al fatto che alcuni lavori stanno scomparendo e altri si sviluppano. Un po’ come nell’Italia del XIX secolo. La maggior parte delle persone lavorava nei campi, ora saranno sì e no il 2%. La cosa importante da ricordare è che non abbiamo idea di quali saranno i lavori che nasceranno da qui a 20 anni. Se nel 2003 ti avessi detto che oggi ci si può guadagnare da vivere sviluppando applicazioni per smartphone o facendo l’influencer sui social media, non avresti nemmeno capito.»

Meta negli ultimi anni si è concentrata molto sul metaverso e sembra essere rimasta un po’ indietro sull’intelligenza artificiale.

«È solo una questione di attenzione che prima era sul metaverso e ora sull’AI. In realtà Meta investe continuamente nell’intelligenza artificiale da oltre 10 anni. Da quando sono arrivato, nel 2013, gli investimenti non hanno fatto che aumentare. Così come sono aumentati quelli per la realtà virtuale e aumentata».

In che modo l’intelligenza artificiale serve a Meta?

«Ci è molto utile, ad esempio, nella moderazione dei contenuti. Propaganda neonazista, tentativi di corrompere il sistema elettorale, pedopornografia e pedofilia. Ci sono stati progressi enormi in questo campo. Prendiamo ad esempio il discorso d’odio. Cinque anni fa l’AI riconosceva ed eliminava automaticamente il 25% dei post che lo contenevano. Il resto veniva controllato da operatori umani manualmente. L’anno scorso lo stesso dato era al 95%. L’AI può essere addestrata a lavorare in ogni lingua e questo ci aiuta moltissimo. Funziona molto bene con i contenuti violenti, ma decisamente peggio, ad esempio, con la disinformazione. Una poesia potrebbe essere scambiata per un’informazione fuorviante e il post eliminato senza che ce ne sia l’effettivo bisogno. Di una cosa sono sicuro: l’AI aiuta di più chi la vuole usare bene di chi la vuole usare male.»

Cosa succede a oggi a chi crea e diffonde su Meta immagini create con l’AI per compiere abusi?

«Quello che conta è evitare che le persone vengano ingannate e prendano per vere cose false. Ci sono tecnologie in grado di identificare con ottimi livelli di accuratezza se un’immagine è stata creata dall’intelligenza artificiale o meno. Ciò che sarebbe utile è un sistema di tracciamento che permetta di identificare immediatamente un’immagine e la sua origine, così sarebbe molto più semplice stabilire la provenienza di un determinato dato e quindi tracciarne la diffusione. Ma non si tratta di una questione solo tecnologica, per mettere in piedi un sistema di questo tipo serve organizzazione sociale e legislazione».

Copyright dell’immagine: Open